Hallottál már arról hogy “SEO”? Hát ha nem, azért ne haragudj meg magadra, mert általában az emberek többsége nem igazán hallott róla. Ez valójában annyit jelent, hogy keresőoptimalizálás. A google és a bing, vagy a DuckDuckGo mindegyik egy olyan kereső, amelyik a nap 24 órájában keresi a weboldalakat és elraktározza az adatbázisban azok címét és bemutató szövegét, leírását, teszi azt a robot a weblapok bejegyzéseivel is. Ez valójában a Google lényege, a keresési szokások és a weboldalak közötti hivatkozások alapján rangsorolja számodra a találati listát – ha egy oldalra, vagy azon belül egy cikkre sok másik helyen hivatkoznak egy linkkel ILYENNEL MINT EZ akkor azt a tartalmat a keresőrobot bizonyos keresési szavakra előrébb rangsorolja. A SEO szakemberek leggyakrabban azzal foglalkoztak, hogy link hálózatokat építettek, ezzel próbálták meg befolyásolni egy-egy weboldal rangsorolását a google-ben. Bevett szokás volt még, hogy rengeteg kulcsszót elhelyeztek a weboldal szövegében, hogy a robot relevánsabbnak “gondolja” a tartalmat…

Azonban a google algoritmusa rengeteget fejlődött az elmúlt 10-15 évben és a fenti praktikák felfedezésekor a találati listán nemhogy előrébb, hanem hátrébb kerültek a fentiek alapján “hackelt” weboldalak. A google büntetett, megjelent az első algoritmus amit hivatalosan publikáltak Panda néven – ennek feladata a csaló weboldalak feltérképezése és büntetése volt. Új módszerek után kellet nézni, felfedezték a “szakemberek”, hogy a találati lista gyakorlatilag személyre szabott és élőben változik, minél többen klikkelnek egy adott oldalra, a találati listáról, annál előrébb jelenik majd meg a következő keresőnek az adott weboldal keresési listán. Így hát elterjedtek a klikkelő robotok, nem kis összegekért árultak ilyen eszközöket, melyek több ip-címet is használnak egyszerre és szimulálják a látogatásokat – a robot automatikusan behívja google találati listáját és mindig az általunk preferált weblapra klikkel… Természetesen a google ezeket a simliket is kiszúrta egy idő után és inkább negatív, mint pozitív hatása volt a dolognak.

A Google eljutott odáig is, hogy a weboldalakat a sebességük (betöltési idejük) alapján is rangsorolta, amelyik oldal túl sokáig várakoztatta a felhasználót, az hátrébb került a találati listán.

És most kezd érdekessé válni a dolog! A fenti büntetéseket ugyanis akkor is meg lehetett kapni a google-tól, ha nem mi csináltuk a saját weboldalunkkal a csalásokat, hanem a konkurens weboldalak “szakemberei”. Ha egy weboldalra több száz hivatkozás mutatott büntettet oldalakról, akkor azt a weboldalt látszólag csaláson érte a google és megbüntette. Ezzel eljött a BLACK-SEO korszaka. Ha egy oldal folyamatos támadást kapott és lassabban töltött be, akkor azt büntette a google. Képzeljük csak el, micsoda lehetőség ez a politikusoknak, semmi dolguk nincs csak a politikai ellenfelük híroldalának a betöltését késleltetni – ezzel hátrébb kerül a találati listán. Bizony – jól gondolod – ez az internetszolgáltatókon keresztül is kivitelezhető! Ezért is foglalhatta törvénybe Barack Obama, hogy az internetszolgáltatók minden tartalmat kötelesek ugyanolyan gyorsasággal és sávszélességgel kiszolgálni.

Mi a fene az a netsemlegesség? És kit érdekel?

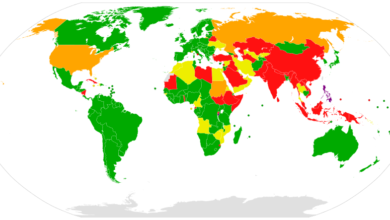

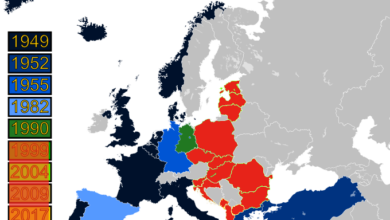

A netsemlegesség tételmondata, hogy a netszolgáltatóknak elfogulatlan és egyenlő hozzáférést kell biztosítaniuk minden internetes oldalhoz és szolgáltatáshoz. A probléma ott kezdődik, hogy ha néhány netszolgáltató túl nagyra nő és túl erős lesz, ez a pár óriás – Amerikában a Comcast, a Verizon, az AT&T és hasonló cégek – dönti el, hogy mi és hogyan juthat el a felhasználókhoz. A tartalomszolgáltatóknak nincs választásuk, mindenképpen csak rajtuk keresztül tudják elérni az embereket, ők az internet kapuőrei. (Még akkor is, ha mára az internethálózat jóval komplexebbé vált, mint amikor a netsemlegesség elvét megalkották. Erről itt írtunk részletesebben.)

Hogy a visszaéléseknek elejét vegye, a jelenlegi szabályozás előírja, hogy a szolgáltatók

- nem vághatják el önkényesen a felhasználókat semmilyen tartalomtól;

- nem részesíthetnek előnyben egyes szolgáltatásokat (akár gyorsabb, akár olcsóbb eléréssel), illetve nem szoríthatnak háttérbe másokat;

- pláne nem kérhetnek pénzt más cégektől azért, hogy cserébe gyorsabb hozzáférést (úgynevezett gyorsforgalmi sávokat) adjanak a felhasználóknak az ő szolgáltatásukhoz, mint a vetélytársakéhoz. INDEX.HU

A fenti idézetben a legfontosabb tétel a jelen vizsgálódásom szempontjából az hogy “a netszolgáltatóknak elfogulatlan és egyenlő hozzáférést kell biztosítaniuk minden internetes oldalhoz” Ugyanis ebben benne foglaltatik nézetem szerint az is, hogy minden oldalt ugyanazzal a gyorsasággal (DNS feloldás, sávszélesség) kell kiszolgálni. Nézzük csak mi történik, ha egy-két másodpercet késik egy weboldal? Semmi különös, csak lehet, hogy “visszamegy” a látogató a kereséséi oldalra és ráklikkel a másik hivatkozásra – ez a legrosszabb eset, ugyanis a google többé lehet, hogy nem is ajánlja fel annak a felhasználónak azt a weboldal, majd ha ez több felhasználóval is előfordul akkor bizony senkinek sem fogja felajánlani. Ebben az esetben a látszólag megmarad a demokratikus elvek alapján működő internet, úgy vesztik el weboldalak a látogatottságukat, hogy nincsenek kitiltva sem az internetszolgáltató hálózatáról, sem a felhasználók tűzfalán keresztül.

Donald Trump-nak ez első intézkedései egyike volt ezt a törvényt eltörölni, hivatkozva arra, hogy megfojtja az egészséges versenyt.

Néhány hónap múlva új mutatók alapján rangsorolja majd a keresési eredményeknél megjelenő oldalakat a Google.

A Google igen elkötelezetten harcol azért, hogy a keresési eredmények (vagyis az ott felbukkanó webhelyek) valamilyen jól követhető rendszer szerint jelenjenek meg. Ez a jövőben sem lesz másképp, sőt: a cég további változtatásokat eszközöl majd algoritmusán, emellett több új mutatót is bevezet annak érdekében, hogy könnyebben lehessen meghatározni egy oldal “sikerességét”. Így pedig azt is, hova kerüljön a találati listán.

A változtatás egyik következménye az oldalon tapasztalható felhasználói élmény (Page experience) faktor bevezetése. Ez elsősorban az oldal betöltésének gyorsaságát ellenőrzi majd, és számszerűsíti azt a kérdést, elég jól működik-e ahhoz, hogy a felhasználónak ne okozzon fejfájást, amikor megnyitja. Ezt persze nem csak a betöltés sebessége határozhatja meg, de a Google elsődlegesen ezt a szempontot tervezi figyelembe venni.

A változtatások szorosan összefüggnek a cég által már bejelentett, “Web Vitals” nevű szempontrendszerrel, amely három paraméter alapján határozza meg, melyek azok a jellemzők, amelyek a Google szerint nélkülözhetetlenek a megfelelő internetes élmény biztosításához. A három paraméter egyike az LCP (Largest Contentful Paint), amely az oldal sebességét nézi, a FID (First Input Delay) a webhely használhatóságát, a CLS (Cumulative Layout Shift) pedig az oldal élvezhetőségét.

A Google a saját hírgyűjtő oldalát már korábban átszabta, amelynek következményeként sokkal látványosabban, de egymástól jól elkülöníthető módon jelennek meg az itt felbukkanó írások. A keresőcég közlése szerint az algoritmusbéli változásnak itt is érzékelhető hatása lesz, ami adott esetben egyes híroldalak “vesztét” is okozhatja: ha ugyanis a Google által vizsgált élményfaktor nem elég jó, a szájt értelemszerűen nem is jelenik majd meg kiemelt helyen. Ez a The Verge összefoglalója szerint valahol ugyanakkor szükséges és érthető lépés, mivel a mai napig előforduló probléma, hogy félreérthető, akár veszélyes tartalmú oldalak jelennek meg itt.

Az algoritmussal kapcsolatos változás a cég közlése szerint csak hónapok múlva esedékes, de az jól látszik, hogy bizonyos webhelyeknek elkerülhetetlen lesz fejleszteni, adott esetben átalakítani a portálukat, ha nem akarnak hátrányba kerülni. Ez azonban egyébként is szükséges lépés lenne. Hiszen ki az az internetező, aki egy lassú, problémás weboldalra akar fellépni? Írja a HVG

A fentiek alapján, felvetődik a kérdés, hogy melegágya lesz-e a “betámadás-bevédésnek” az internet. Vajon védelmi hálóba kell helyezni majd a szervereket, hogy elkerüljék az üzemeltetők a kitiltást? Vajon kis cégek lehúzhatják majd a rolót? – mert nem bírnak akkora infrastruktúrát fenntartani, ami ahhoz szükséges, hogy a googlnek meg tudjanak felelni? Tényleg minden tartalmat a világon a végtelenségig le kell butítanunk a mobiltelefonok szintjére? Vajon nem lenne jobb megoldás a külön találati lista a mobil és az asztali gépeknek?

Majd elválik mi lesz, addig is olvasgasd nálunk a híreket, mi nem rangsorolunk a tartalmat, megjelenésükkel párhuzamosan időrendben publikáljuk őket.